【Docker】软件安装

wechatbot

- 安装wechatbot

- 进入容器

- 查看二维码

vim

- 进入容器

- 配置网易的镜像源

- 安装vim编辑器

如果想安装其他工具的话,可以使用

apt-get install命令

MySQL

- 下载指定版本的MySQL镜像

- 运行MySQL容器

- 进入MySQL容器,并登录客户端

- 修改root密码

- 添加远程登录用户

- 修改MySQL配置文件

在

[mysqld]下添加你的配置,比如

sql_mode=

MySQL集群(单机多容器)

- 拉取pxc镜像

- 创建一个单独的网段,给mysql数据库集群使用

- 创建3个卷

- 创建三个容器

-v v1:/var/lib/mysql:容器中的/var/lib/mysql路径映射到宿主机的v1卷

-e CLUSTER_NAME=pxc:指定集群的名称

-e XTRABACKUP_PASSWORD=123456:指定集群内节点通信的密码

--net=pxc-net:指定集群使用的网络

--ip 172.20.0.2:指定节点的ip地址

f1439de62087:镜像ID

-e CLUSTER_JOIN=pxc_node01:加入某个节点组成集群

haproxy

- 拉取haproxy镜像

- 创建haproxy配置文件,这里使用bind mounting的方式

- 填下如下配置内容

- 创建haproxy容器

-v /tmp/haproxy:/usr/local/etc/haproxy:容器中的/usr/local/etc/haproxy目录映射到宿主机的/tmp/haproxy目录

- 根据haproxy.cfg文件启动haproxy

- 在MySQL数据库上创建用户,用于心跳检测

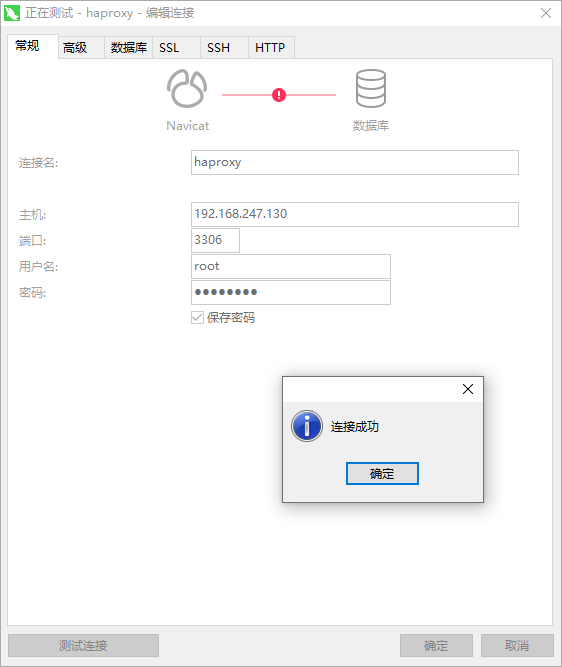

- 使用mysql客户端连接

redis

- 宿主机新建redis数据文件目录

- 拷贝redis官方配置文件并修改

- 修改如下内容

- 下载指定版本的Redis镜像

- 运行Redis容器

-p 6479:6379:把容器内的6379端口映射到宿主机6479端口

-v /data/redis/redis.conf:/etc/redis/redis.conf:把宿主机配置好的redis.conf和容器中的配置文件做双向绑定

-v /data/redis/data:/data:把redis持久化的数据在宿主机内显示,做数据备份

redis-server /etc/redis/redis.conf:这个是关键配置,让redis不是无配置启动,而是按照这个redis.conf的配置启动

- 进入Redis容器,并登录客户端

- 查看Redis版本

kafka

- 进入Kafka容器

xxl-job-admin

- 拉取镜像

- 创建容器

weavescope

- 安装命令

harbor

- 下载软件:https://github.com/goharbor/harbor/releases

- 找一台安装了docker-compose的机器,上传并解压

- 进入到解压缩的harbor目录,修改harbor.yml文件

- 修改如下内容

- 运行启动脚本

nginx

- 拉取nginx最新版镜像

- 在主机的

/tmp/nginx下新建nginx.conf文件,并进行相应的配置

- 修改如下内容

- 创建nginx容器

-v /tmp/nginx/nginx.conf:/etc/nginx/nginx.conf:宿主机/tmp/nginx/nginx.conf配置文件映射容器/etc/nginx/nginx.conf配置文件

--network=pxc-net:指定容器使用的网络为pxc-net

--ip 172.20.0.20:指定容器的ip为172.20.0.20

spring boot项目

- spring boot项目使用如下命令打包

- 在服务器上新建一个目录springboot-mybatis

- 上传spring boot项目包到springboot-mybatis目录

- 在springboot-mybatis目录下编写docker file文件

- 新增如下内容

- 基于docker file构建镜像

- 基于镜像创建容器

- 查看spring boot项目日志

portainer

- 安装server

- 安装agent

cadvisor

- 用途:采集Docker容器指标数据

- 安装

prometheus

- 安装

- 修改配置文件prometheus.yml

grafana

- 安装

jenkins

- 安装

postgres

- 安装

POSTGRES_PASSWORD:设置postgres密码

SonarQube

- postgres数据库创建账号

- 创建SonarQube的Docker的volumes

- 安装SonarQube

filebeat

- 下载镜像

- 创建配置文件

- 启动容器

PhpMyAdmin

- 基本安装命令

PMA_HOST:要连接的MySQL服务器的地址

评论区